Алгоритм научился распознавать напечатанный юзером текст по записи с микрофона

Deep learning алгоритм смог с точностью 90+ процентов распознать напечатанный текст по звукам нажатия клавиатуры. При этом он справился со звуками, которые записали как на микрофоне телефона, так и через запись с Zoom'a или скайпа. Пока алгоритм тестили только на клавиатуре MacBook pro, но разработчики считают, что и с другими клавиатурами можно провернуть аналогичное.

Команда исследователей из британских университетов обучила модель, которая может похищать данные из записи звуков нажатия на клаву, записанных с помощью микрофона, с точностью 95%. Когда для обучения алгоритма юзался Zoom, точность прогнозирования снизилась до 93%. Такая атака серьезно влияет на безопасность данных жертвы, так как может привести к утечке паролей, переписки или другой конфиденциальной информации.

Давайте рассмотрим детали

Первый шаг атаки заключается в записи нажатий клавиш на клавиатуре цели, так как эти данные необходимы для обучения алгоритма.

В качестве альтернативы, нажатия клавиш могут быть записаны через звонок в Zoom, где участник встречи устанавливает связь между сообщениями, набранными целью, и их звуковой записью.

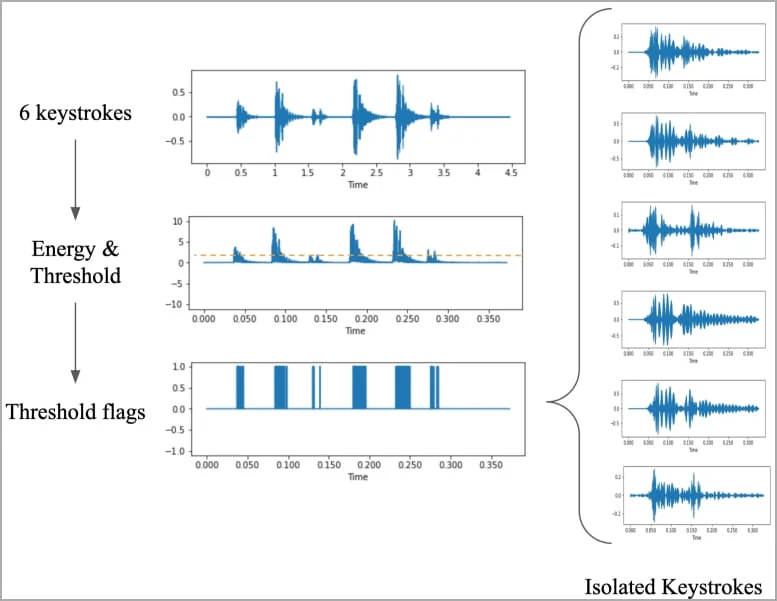

Исследователи собрали обучающие данные, нажимая 36 клавиш на новом MacBook Pro 25 раз каждую и записывая звук, производимый каждым нажатием.

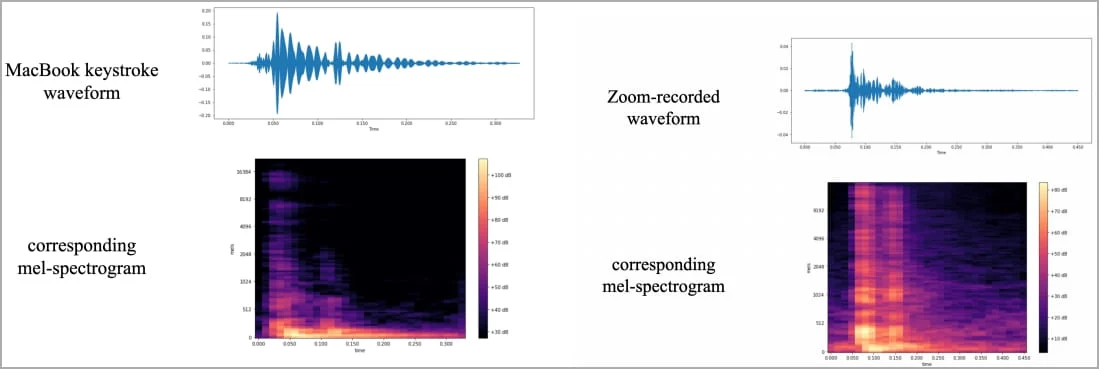

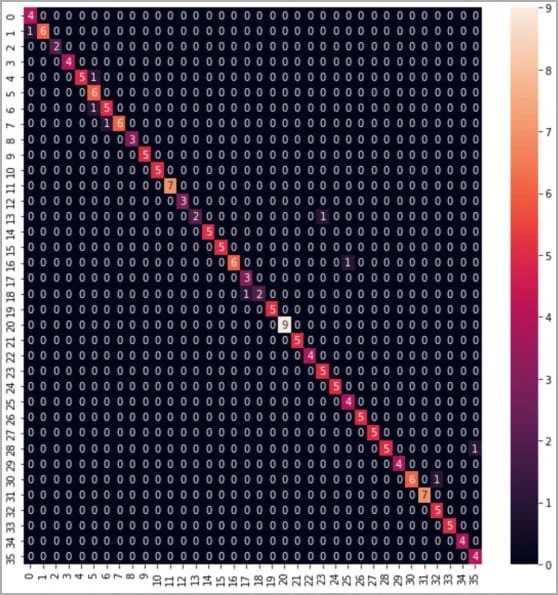

Затем они создали волновые формы и спектрограммы из записей, которые визуализировали различия, идентифицируемые для каждой клавиши, и выполнили конкретные шаги по обработке данных для усиления сигналов, которые можно использовать для идентификации нажатий клавиш.

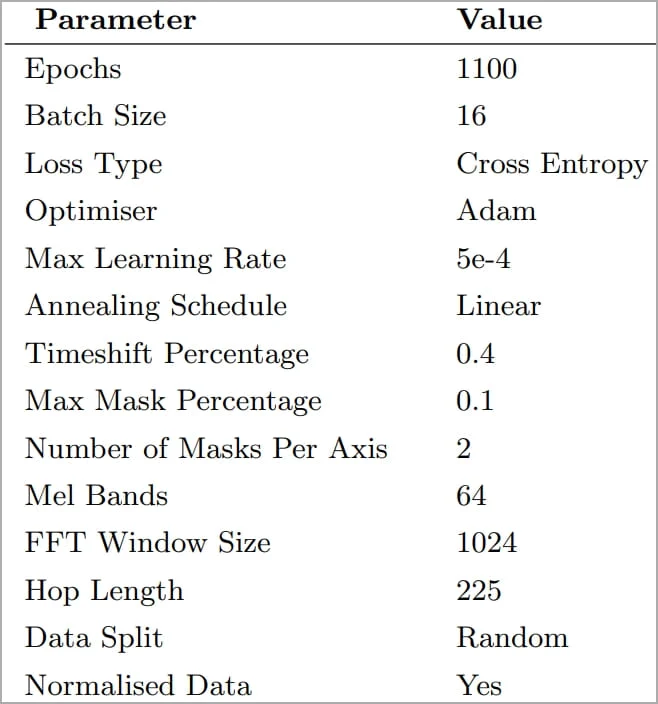

Спектрограммы использовались для обучения "CoAtNet" - классификатора изображений. В процессе потребовалось экспериментировать с параметрами, скорости обучения и разделения данных, пока не были достигнуты лучшие результаты точности прогнозирования.

В своих экспериментах исследователи использовали один и тот же ноутбук, клавиатура которого используется во всех ноутбуках Apple в течение последних двух лет, iPhone 13, размещенный на расстоянии 17 см от цели, и Zoom.

Классификатор CoANet достиг 95 % точности на записях, сделанных со смартфона, и 93 % на записях, сделанных через Zoom. Skype показал более низкую, но все же приемлемую точность - 91,7%.

Полное исследование доступно по ссылке.